이번주 AI 뉴스 📰

AI '레드라인' 설정 촉구... 전 세계 지도자·석학들, 국제 협약 요구

글로벌 공동 촉구 : 전직 국가 원수, 노벨상 수상자, AI 전문가 등 200여 명이 2026년까지 AI '레드라인' 국제 협약을 촉구함.

위험 사전 방지 : 인간 흉내나 자가 복제 등 AI가 결코 해서는 안 될 일을 규정해 돌이킬 수 없는 위험을 사전에 방지하는 것이 목표임.

국제기구 필요성 : 자발적 규제만으로는 부족하며, 레드라인을 정의하고 감독할 강제력 있는 국제기구가 필요하다고 주장함.

엔비디아, OpenAI에 1000억 달러 투자... '슈퍼인텔리전스' 개발 동맹

초거대 AI 동맹 : 엔비디아가 최소 10기가와트 규모의 AI 데이터센터 구축을 지원하고 최대 1000억 달러를 투자하는 전략적 파트너십을 체결함.

미래 경제 기반 : 양사는 이 컴퓨팅 인프라가 미래 경제의 기반이 되며 새로운 AI 혁신을 만드는 데 사용될 것이라고 밝힘.

MS 독점 탈피 : 이번 협력은 MS와의 컴퓨팅 독점 관계가 종료된 후 파트너를 다각화하려는 OpenAI의 전략적 행보로 풀이됨.

"AI에 뒤처지면 MS도 사라진다"... 나델라 CEO의 절박한 위기감

CEO의 위기감 : 사티아 나델라 CEO가 AI 시대에 적응 못 하면 과거의 거대 기업(DEC)처럼 사라질 수 있다며 강한 위기감을 표출함.

핵심 사업 위협 : AI가 MS 오피스 등 핵심 제품의 기능을 대체 가능해, 40년간 유지해온 주력 사업이 무의미해질 수 있다고 경고함.

AI 전환 가속화 : 위기 대응을 위해 구조조정과 함께 코파일럿·윈도우 책임자를 사장으로 승진시켜 미래 AI 전략에 힘을 싣고 있음.

이번주 AI 논문 📝

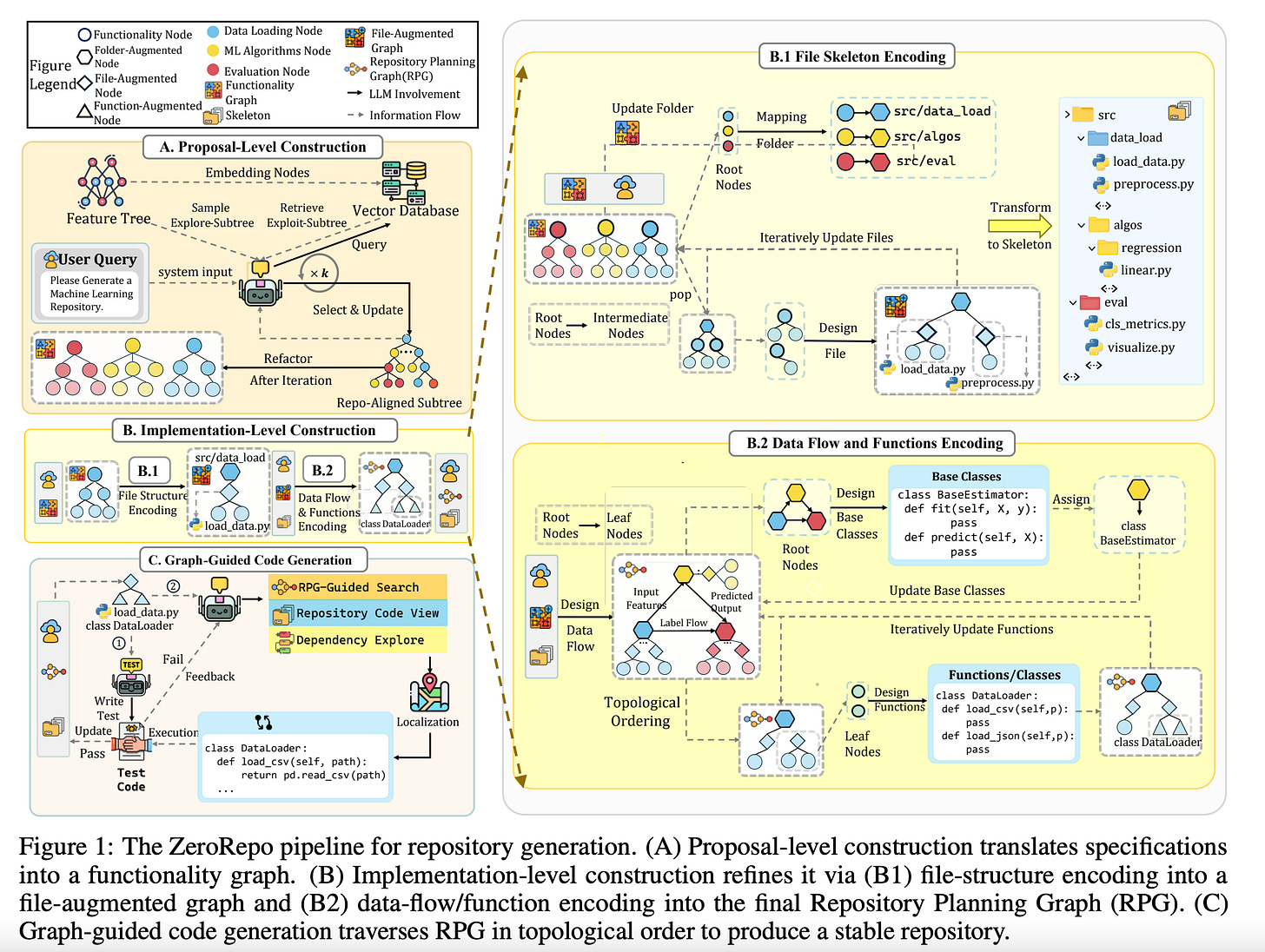

RPG: 통합 계획 그래프를 이용한 확장 가능한 전체 코드 저장소 생성

기존의 한계 : 기존 LLM은 모호한 자연어 계획에 의존하여 전체 코드 저장소를 일관성 있게 생성하는 데 어려움을 겪었음.

그래프 기반 해법 : 코드 구조와 데이터 흐름을 명시하는 '리포지토리 계획 그래프(RPG)'를 설계하고, 이를 기반으로 코드를 생성하는 ZeroRepo 프레임워크를 개발함.

압도적인 성능 : 새로운 벤치마크에서 기존 최고 모델보다 월등히 큰 규모의 코드를 생성했으며, 기능 완성도와 테스트 통과율도 크게 향상시킴.

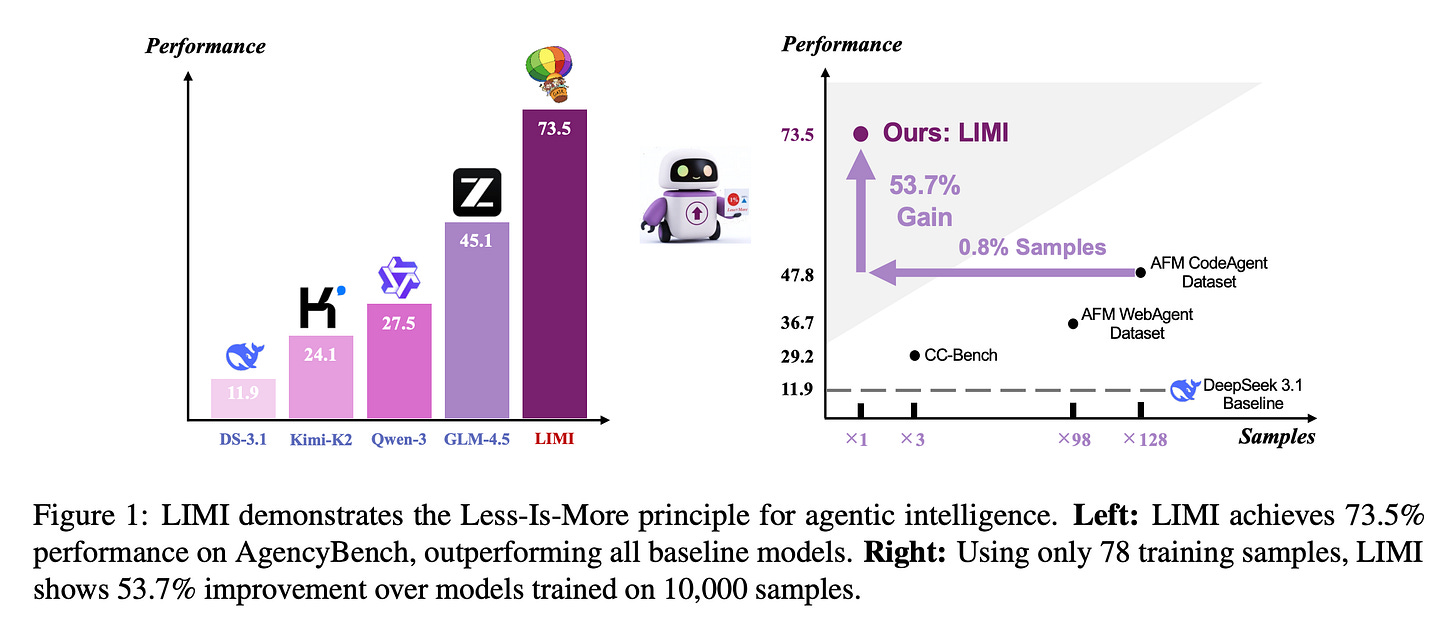

LIMI: AI 에이전트 개발, 데이터의 양보다 질이 핵심이다

기존의 통념 : AI가 스스로 일하게 만드는 '에이전트' 개발 시, 무조건 데이터가 많아야 똑똑해진다는 통념이 있었음.

LIMI의 역발상 : 이 통념을 뒤집어, 전략적으로 엄선된 소수의 고품질 데이터만으로도 뛰어난 에이전트 지능을 구현할 수 있음을 제안함.

압도적 성능 증명 : 단 78개의 데이터로 학습한 LIMI가 수만 개 데이터로 학습한 모델을 압도하며, '에이전트 효율성 원칙'을 새롭게 정립함.

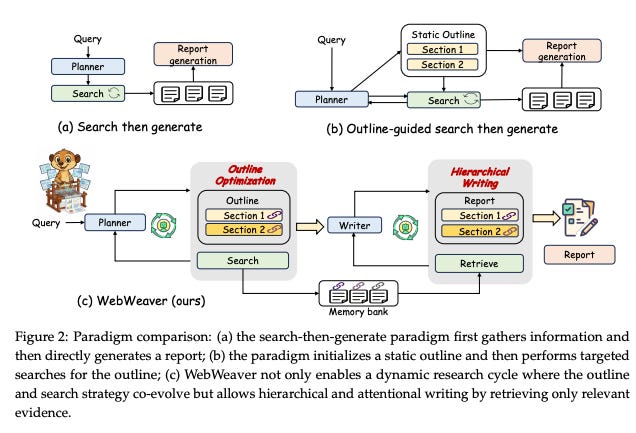

WebWeaver: 방대한 웹 정보를 똑똑한 개요로 정리하는 심층 연구 AI

기존 AI의 한계 : 기존 AI 연구 방식은 정해진 순서에 갇혀있고 긴 글의 내용을 중간에 잊어버리는 등 부정확한 결과를 내는 한계가 있었음.

WebWeaver의 방식 : ‘기획자’와 ‘작성자’ 역할을 맡은 두 AI가 서로 협력하여, 자료를 찾고 개요를 발전시키는 과정을 유연하게 반복하며 보고서를 완성함.

뛰어난 연구 결과 : 여러 성능 평가에서 최고 수준의 점수를 획득했으며, 이를 통해 신뢰도 높고 체계적인 보고서 작성 능력을 성공적으로 증명함.

이번주 AI 프로덕트 🎁

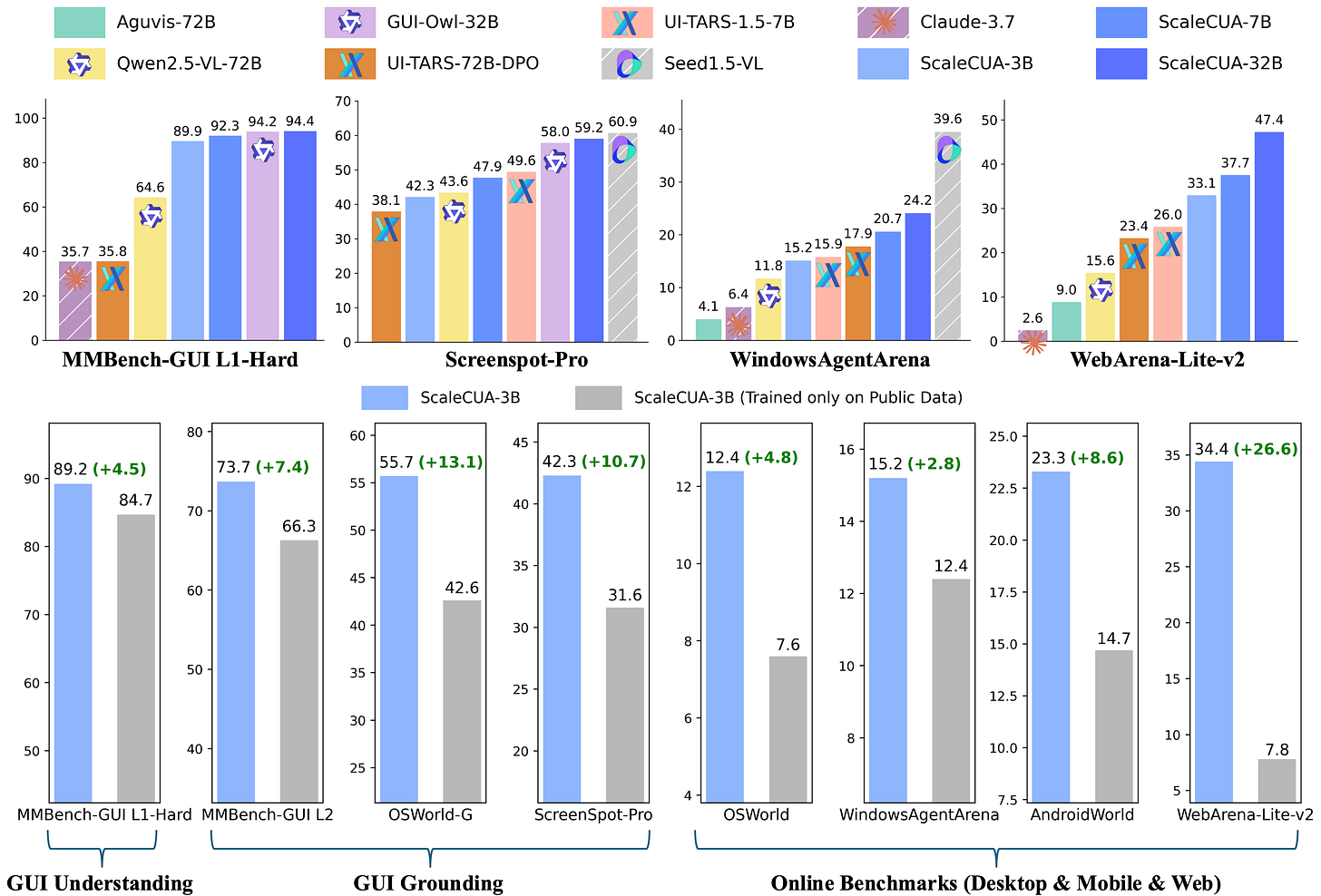

ScaleCUA: 크로스플랫폼 대규모 데이터셋이 이끄는 오픈소스 컴퓨터 제어 AI의 확장

데이터 부족 문제 : 컴퓨터를 자율적으로 사용하는 AI 에이전트의 발전은 대규모 오픈소스 학습 데이터의 부재로 인해 더뎠음.

ScaleCUA의 제안 : 6개 운영체제를 아우르는 대규모 데이터셋을 구축하고, 이를 학습하여 플랫폼 제약 없이 작동하는 모델을 개발함.

뛰어난 성능 입증 : 다양한 벤치마크에서 기존 모델 성능을 크게 뛰어넘는 최고 수준(SOTA)의 점수를 기록하며 데이터 기반 확장의 효과를 증명함.

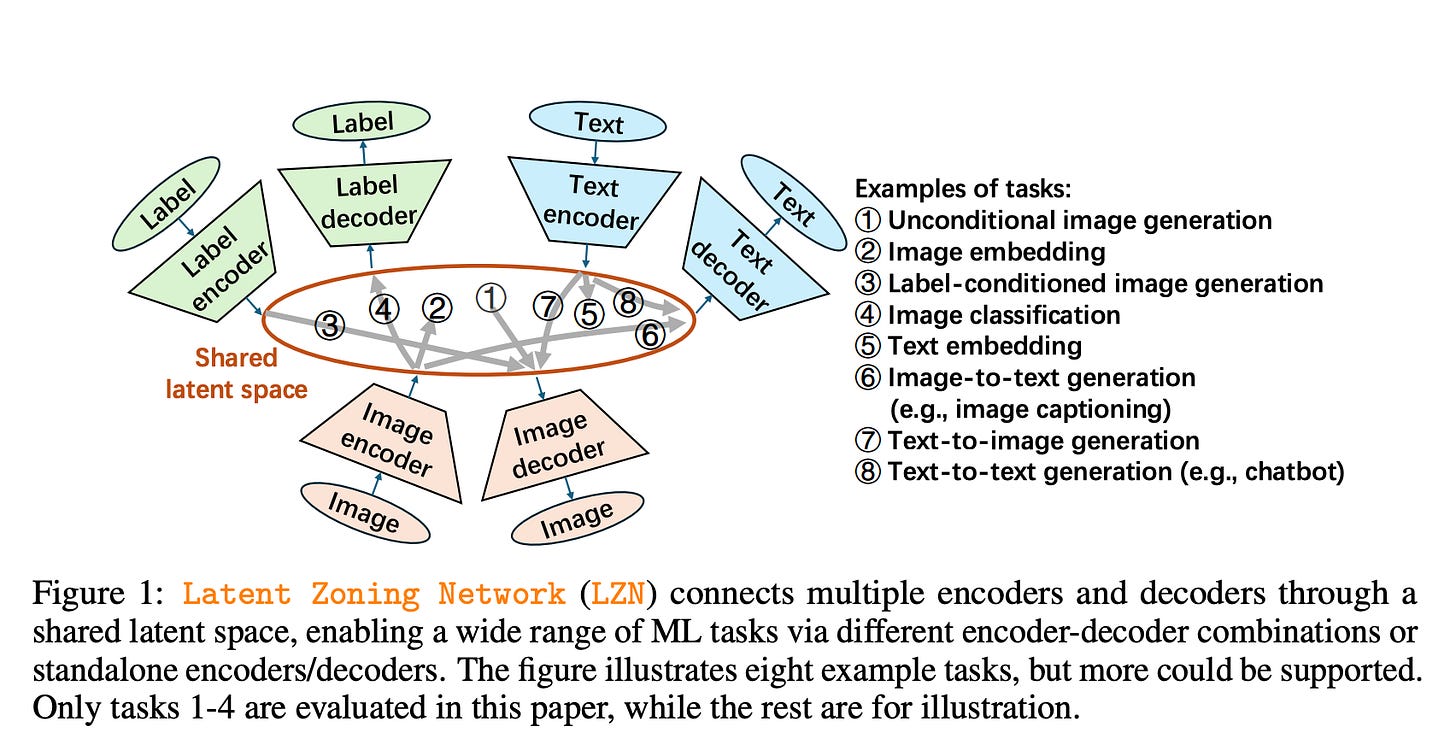

LZN(잠재 공간 구역화): 생성, 분류, 표현 학습을 통합하는 단일 프레임워크

분리된 연구 분야 : 이미지 생성, 분류, 표현 학습은 머신러닝의 핵심 분야지만, 지금까지 각기 다른 모델로 개별적으로 연구되어 왔음.

LZN의 통합 원리 : 단일 잠재 공간을 여러 '구역'으로 나누고, 각 데이터 타입을 해당 구역에 매핑하는 구조로 세 가지 핵심 과업을 통합함.

통합의 효과 증명 : 실제 실험에서 기존 생성 모델의 성능을 향상시켰을 뿐만 아니라, 분류와 생성을 동시에 수행하며 최고 수준의 정확도를 달성함.