이번주 AI 뉴스 📰

메타, AI 이미지 최강자 'Midjourney'와 손잡았다

미드저니와 제휴 : AI 이미지 & 영상 기술 경쟁력 강화를 위해 Midjourney와 기술 라이선스 파트너십을 체결함.

AI 패권 경쟁 : OpenAI 'Sora', Google 'Veo' 등 경쟁 모델에 대항하기 위한 전략적 움직임으로 풀이됨.

독립성 유지 : Midjourney는 이번 제휴와 무관하게 외부 투자 없이 독립적으로 운영될 것이라고 밝힘.

새 이미지 모델 : 구글이 챗GPT와의 경쟁을 위해 제미나이에 새로운 AI 이미지 모델 '2.5 플래시 이미지 (nano-banana) '를 26일 출시함.

정교한 편집 기능 : 인물 얼굴 등 주요 요소는 유지한 채 특정 부분만 자연스럽게 수정하는 정교한 편집 기능이 특징임.

안전장치 강화 : 과거 이미지 생성 오류를 반복하지 않기 위해 딥페이크 방지 워터마크 등 안전장치를 대폭 보강함.

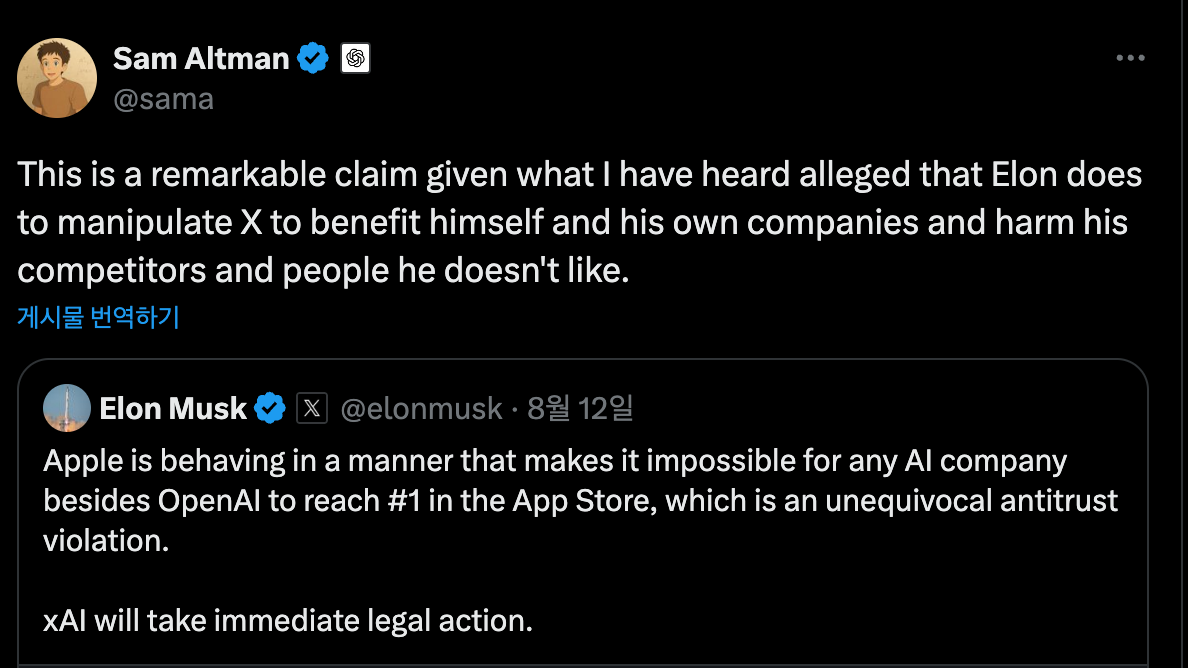

머스크, 'AI 담합' 주장하며 애플·오픈AI에 소송 제기

반독점 소송 제기 : 일론 머스크 의 xAI가 Apple과 OpenAI를 반경쟁적 담합 혐의로 소송을 제기함.

소송 제기 배경 : Apple이 스마트폰 독점 유지를 위해 AI 시장의 독점 기업인 OpenAI와 협력했다고 주장함.

계속되는 갈등 : 이번 소송은 OpenAI 공동창업자였던 머스크와 샘 알트만 CEO 간의 오랜 갈등의 연장선임.

이번주 AI 논문 📝

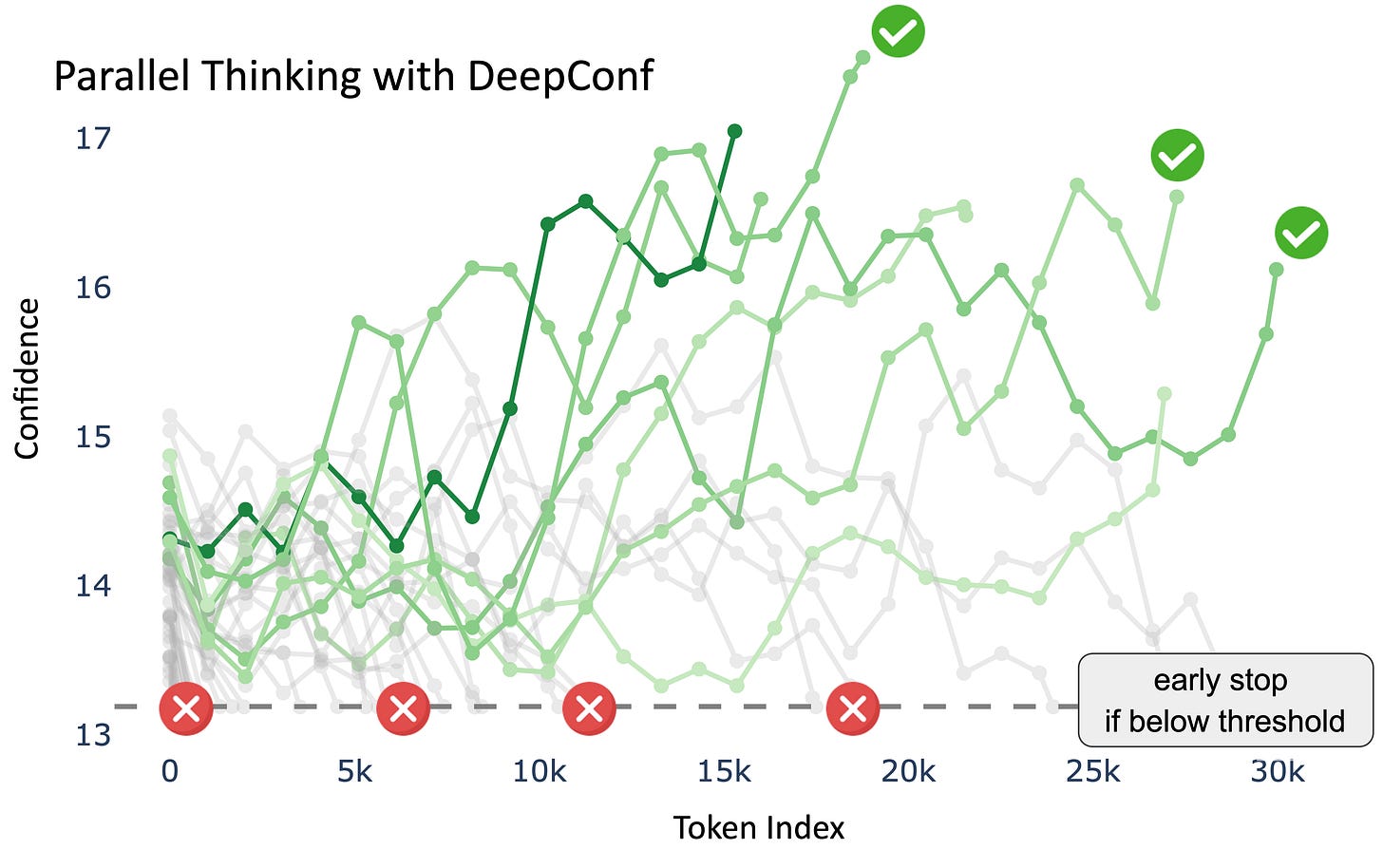

DeepConf: 불필요한 생각은 쳐내고 정답만 찾는 AI

추론 효율 개선 : 기존 LLM의 다수결 추론 방식이 가진 높은 연산 비용과 정확도 한계 문제를 해결하기 위한 새로운 테스트 타임 기법 '딥콘프(DeepConf)'를 제안함.

자체 확신도 활용 : 별도 훈련 없이 모델 내부의 '확신도'를 활용해, 추론 과정에서 품질이 낮은 사고 경로를 동적으로 제거하는 방식으로 작동함.

정확도 및 효율성 입증 : 고난도 벤치마크(AIME 2025)에서 최대 99.9%의 정확도를 달성했으며, 생성 토큰 수를 최대 84.7%까지 절감하며 높은 효율성을 입증함.

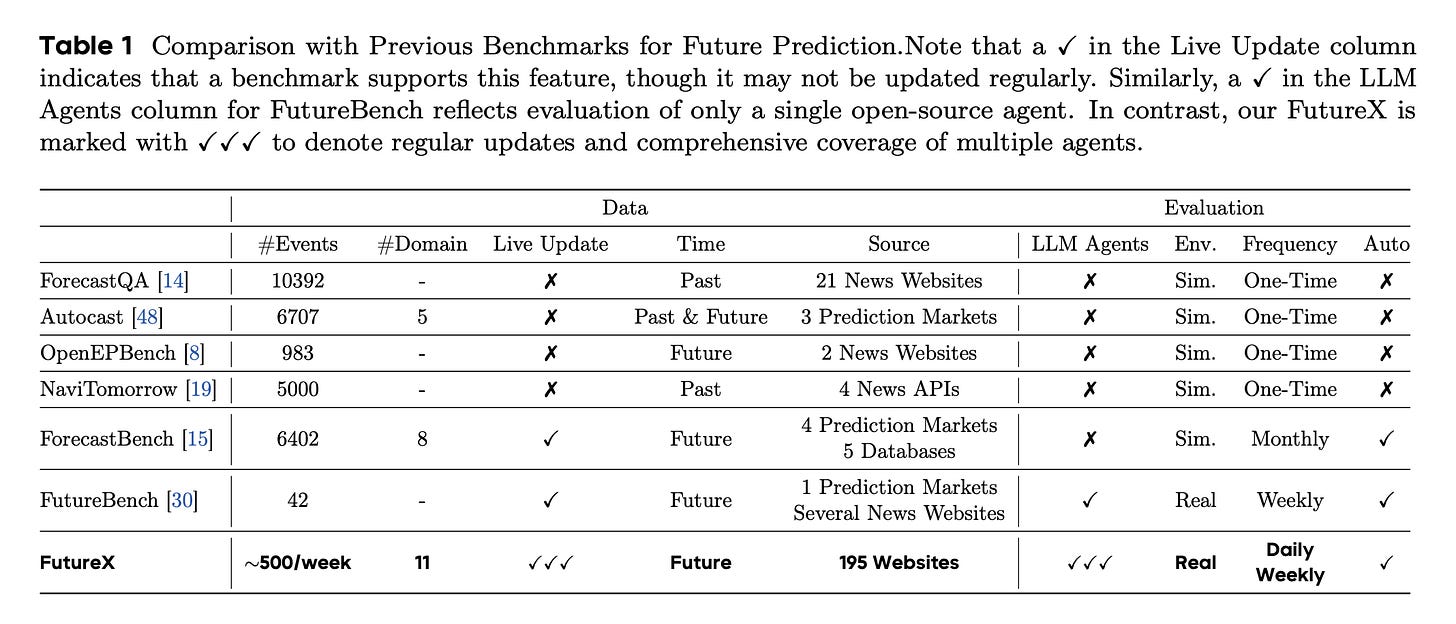

퓨처X(FutureX): AI의 미래 예측 능력을 실시간으로 평가하다

b미래 예측 벤치마크 : LLM 에이전트의 핵심 능력인 미래 예측 성능을 평가할 대규모 벤치마크가 없는 문제를 해결하고자, 실시간 동적 벤치마크 '퓨처X(FutureX)'를 개발함.

실시간 업데이트 및 오염 방지 : 매일 실시간으로 업데이트되며, 질문 수집 및 정답 확인 자동화 파이프라인을 통해 데이터 오염 문제를 원천적으로 차단함.

성능 분석 및 목표 : 25개 모델 평가를 통해 가짜 웹페이지 취약성 등 에이전트의 실패 원인을 심층 분석했으며, 인간 전문가 수준의 AI 개발을 목표로 함.

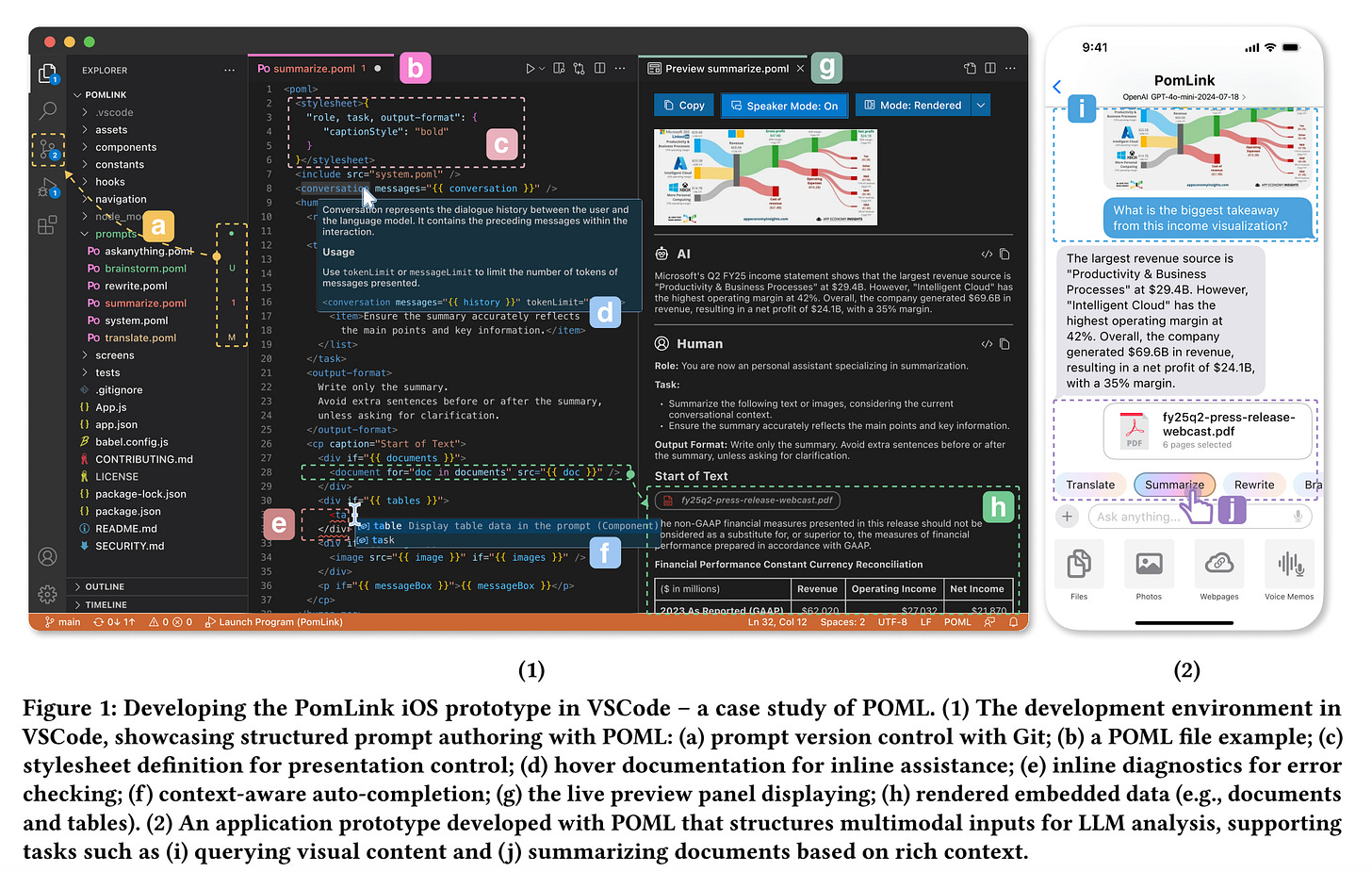

POML(폼): AI 프롬프트를 HTML처럼 체계적으로 설계하다

체계적인 프롬프트 관리 : 복잡한 LLM 프롬프트의 구조화, 데이터 통합, 형식 민감성 문제를 해결하기 위해 새로운 마크업 언어 'POML(Prompt Orchestration Markup Language)'을 제안함.

HTML/CSS와 유사한 구조 : 컴포넌트 기반 마크업으로 논리적 구조를 잡고, CSS와 유사한 스타일링 시스템으로 내용과 표현을 분리하며, 데이터 통합을 위한 전용 태그를 제공함.

개발 편의성 및 성능 입증 : IDE 지원 등 포괄적인 개발자 툴킷을 포함하며, 사례 연구를 통해 복잡한 애플리케이션 통합 및 질의응답 정확도 향상 효과를 입증함.

이번주 AI 프로덕트 🎁

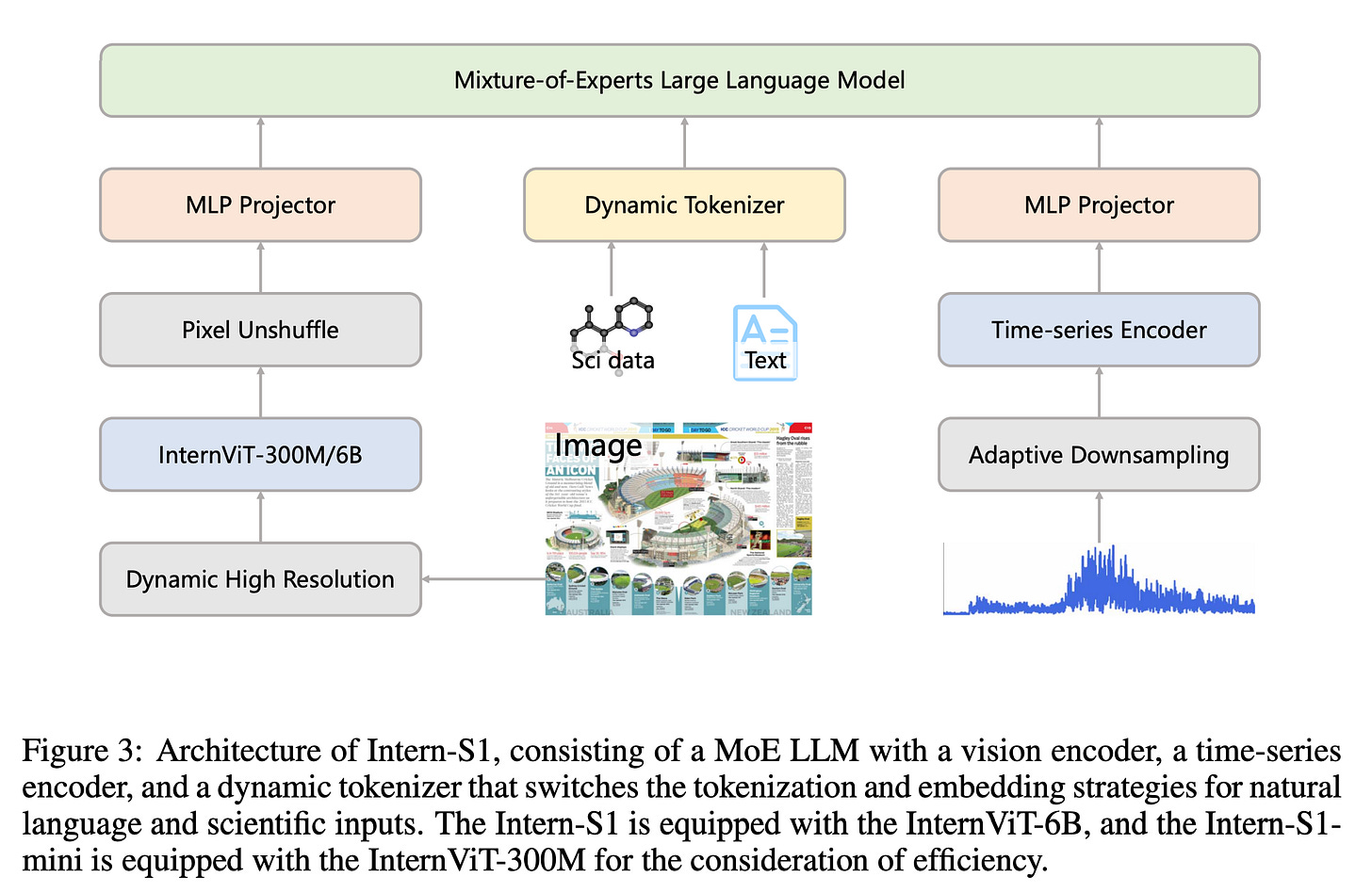

Intern-S1: 과학 분야 멀티모달 파운데이션 모델

과학 분야 격차 해소 : 전문 과학 분야에서 오픈소스와 Closed Source 모델 간의 상당한 격차를 해소하고 인공일반지능(AGI)으로 나아가기 위해 개발함.

모델 특징 및 훈련 방식 : 2410억 파라미터의 멀티모달 MoE(전문가 혼합) 모델로, 방대한 과학 데이터로 사전 학습 후 보상 혼합(MoR) 강화학습 기법으로 미세 조정됨.

SOTA 능가하는 성능 : 일반 추론 과제에서 경쟁력을 보였으며, 분자 합성 계획 등 특정 전문 과학 분야에서는 최첨단(SOTA) 모델을 능가하는 성능을 달성함.

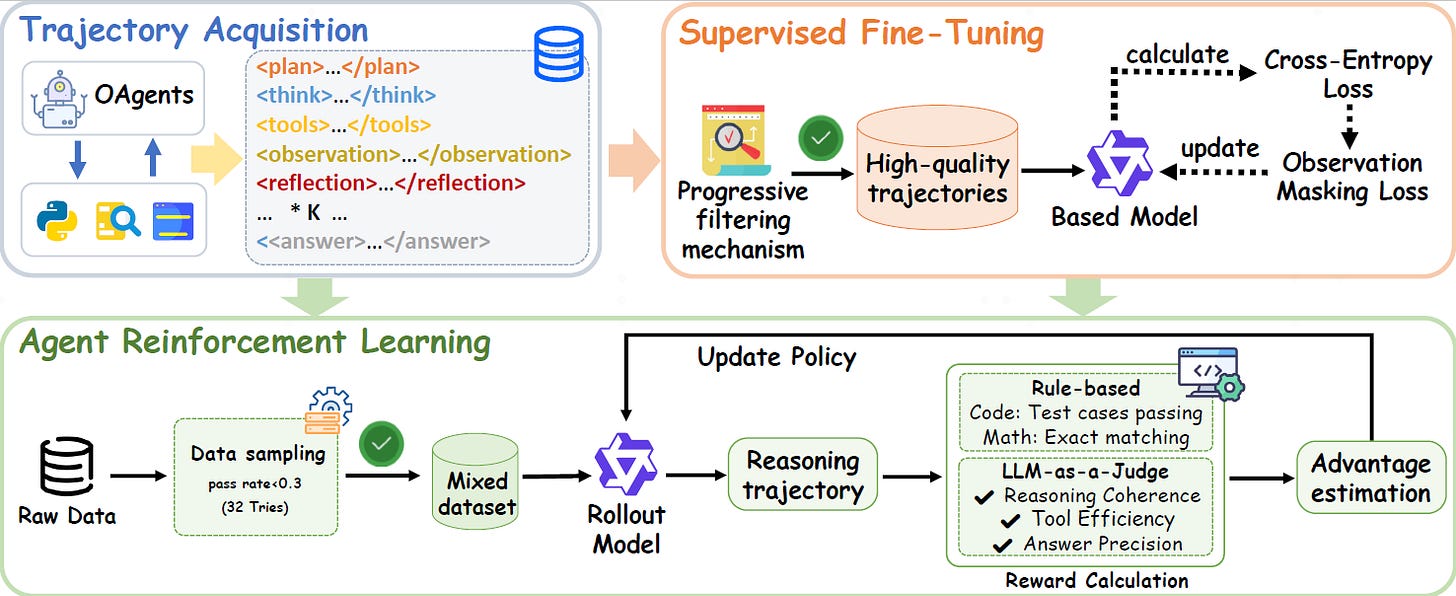

CoA(Chain-of-Agents): AI '드림팀'을 하나의 모델에 담다

단일 모델 내 다중 에이전트 : 기존 다중 에이전트 시스템의 비효율성을 극복하고자, 단일 모델 내에서 여러 에이전트의 협업을 모방하는 새로운 패러다임 'CoA(Chain-of-Agents)'를 제안함.

증류 및 강화학습 : 최신 다중 에이전트 시스템의 과정을 증류해 지도학습하고, 에이전트 강화학습(RL)으로 능력을 더욱 향상시키는 2단계 훈련 방식을 도입함.

새로운 SOTA 달성 : 이 방식으로 훈련된 '에이전트 파운데이션 모델(AFM)'은 웹 및 코드 에이전트 벤치마크에서 새로운 최첨단(SOTA) 성능을 달성했으며, 모든 소스를 공개함.